Zagrożenia

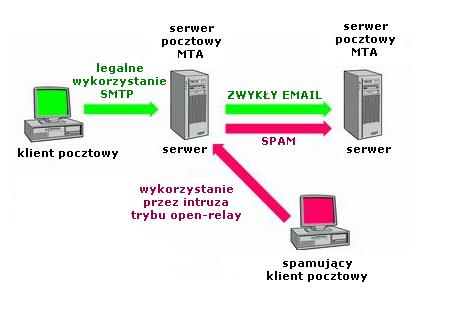

- Open relay

Open relay czyli otwarty przekaźnik poczty

to taki serwer pocztowy, który poprzez SMTP przyjmuje pocztę nie adresowaną do

lokalnego użytkownika, czy też nie wysyłaną przez lokalnego użytkownika.

Możliwość taką wykorzystują głównie spamerzy, wysyłając za pośrednictwem

takich serwerów ogromne liczby reklam, ogłoszeń, itp.

Obecnie większość MTA ma domyślnie

zablokowaną opcję "open-relay" lub jest konfigurowana w taki sposób,

by przyjmować pocztę tylko z określonych domen, czy też tylko od lokalnych

użytkowników (autoryzacja SMTP), mimo to portale takie jak wp.pl czy o2.pl nadal

działają w trybie "open relay".

- wykorzystanie innych błędów w konfiguracji - np. uzyskanie listy kont

użytkowników na potrzeby spamu.

Zabezpieczanie serwera MTA:

- MAPS i RBL

Zbieranie danych o spamerach indywidualnie

przez użytkowników i administratorów usług pocztowych jest dosyć pracochłonne,

opracowano więc "czarne listy" udostępniające swe zasoby klientom, którymi

zazwyczaj są serwery SMTP. Użyteczność tego typu serwisów stoi na równi z

dużym ryzykiem ich używania - przypadkowe wpisanie na listę serwera

instytucjonalnego lub komercyjnego może przynieść dotkliwe szkody, zaś

monitowanie zarządzających tymi serwisami o zabezpieczenie dostępu do cudzych

MTA bywa uciążliwe.

Pod skrótami MAPS (Mail Abuse Prevention

System) i RBL (Realtime Blackhole List) kryje się globalna,

ogólnodostępna baza danych o hostach podejrzanych o rozsyłanie spamu. Wpisanie

konkretnego adresu IP odbywa się na podstawie skarg użytkowników Internetu.

Odpytanie bazy jest proste i wymaga niewielkich tylko rozszerzeń w stosunku do

istniejących już pakietów (np. sendmail), nawet bez ingerencji w ich teksty

źródłowe. Dane z bazy udostępniane są poprzez DNS, a umieszczenie hosta o

adresie IP x.y.z.v na liście oznacza wpisanie nazwy w DNS w postaci

v.z.y.x.blackholes.mail-abuse.org. Istnienie tak sformułowanego adresu

symbolicznego oznacza wpisanie hosta o odpowiednim adresie IP na listę RBL.

Możliwe jest - obok bezpośredniego zapytywania serwera DNS mail-abuse.org -

ustanowienie serwera zapasowego we własnym środowisku i korzystanie z niego,

gdy np. niedostępny jest ten pierwszy. Korzystanie z RBL nie jest trudne nawet

dla osób początkujących w sztuce programowania.

Współpracę z RBL

zapewniają pakiety: sendmail, smail, qmail, zmailer, exim czy postfix.

Liczne są też programy klienckie, rozszerzenia i łaty do innych pakietów

obsługujące RBL, np. do pakietu kontroli dostępu tcp wrappers czy serwera WWW

Apache. Można też korzystać z innych usług, np. DUL (Dialup Users List) czy

RSS (Relay Spam Stopper), która udostępnia adresy hostów umożliwiających

przekazywanie spamu.

- BlackMail

BlackMail działa jako serwer proxy w

stosunku do konwencjonalnego serwera SMTP. Przyjmując pocztę, dokonuje serii

testów, polegających na sprawdzeniu znanych serwerów rozpowszechniających

spam, słów kluczowych w nagłówkach, poprawności adresu e-mail nadawcy i wpisów

DNS nadsyłającego pocztę hosta oraz sprawdzenia występowania hosta w bazie

RBL. Pakiet został napisany z myślą o systemach Unix, współpracuje z kilkoma

popularnymi serwerami MTA (sendmail, smail, qmail). Dostępny bezpłatnie na

zasadach licencji GPL, niestety, dość sporadycznie uaktualniany.

Źródła:

Raport SANS TOP 20-Lista Top 20 Internetowych Luk Bezpieczeństwa

według SANS

http://www.telenetforum.pl/index_2.php?show=pokaz_art_old&art=19_06_2001

http://www.pckurier.pl/archiwum/art0.asp?ID=4762

Opis

Protokół SNMP (Simple Network Management Protocol) służy do zarządzania i

monitorowania urządzeń sieciowych. Jest to protokół opisywany w terminologii

SNMP jako protokół menedżer/agent. Agent działa na obsługiwanym urządzeniu

nazywanym MNE (Managed Network Entity - obsługiwana jednostka sieciowa) i

monitoruje stan urządzenia. Menedżer działa na jednostce NMS (Network Management

Station - jednostka zarządzania siecią) i odbiera raporty od agenta. Dodatkowo

każdy agent SNMP obsługuje własną niewielką bazę danych (MIB - Management

Information Base), zawierającą informacje o stanie i historii pracy urządzenia,

a także zmienne sterujące jego pracą.

Zalety:

instalowane w węzłach programy zajmują mało miejsca w pamięci,

protokół pozwala kontrolować liczbę generowanych przez stację zarządzania

powtórzeń żądań obsługi oraz czas oczekiwania na odpowiedzi urządzeń,

możliwość wychwytywania konkretnych zdarzeń (informacje typu trap),

powszechna dostępność aplikacji opartych na protokole SNMP,

niskie koszty wdrożenia do eksploatacji.

Wady:

skomplikowana pracę samego agenta,

ograniczanie przepustowości sieci,

brak mechanizmów bezpieczeństwa.

Zagrożenia

SNMP staje się częstym celem ataków, gdyż:

- instaluje się go w kluczowych węzłach sieci, przełącznikach szkieletowych,

serwerach i zaporach - udany atak może więc uniemożliwić działanie całej

sieci,

- z jego pomocą można na przykład wyłączyć filtrowanie pakietów przez zaporę

ogniową, co jest przydatne w pierwszej fazie ataku.

Odnalezione

luki:

- wymiana komunikatów przy użyciu protokołu User Datagram Protocol (UDP); a

UDP jest protokołem bezpołączeniowym, w którym nie jest wymagane potwierdzanie

odbioru komunikatu czy uwierzytelnianie nadawcy,

- praca zgodnie z architekturą zarządzania menedżer/agent, gdzie menedżer

wymienia z agentem informacje w trybie synchronicznym (zgodnie z procedurą

żądanie/odpowiedź); taka architektura nie sprawdza się i powinna być

zamieniona na architekturę opartą na zdarzeniach, w której komunikaty mogą być

wymieniane w trybie asynchronicznym.

Źródła

http://www.eltronik.net.pl/index.pl/informacje_techniczne2#1152

http://hip.ipadmin.info/own/mrtg/mrtg_referat.htm

http://www.okmatura.cad.pl/infa/029.htm

http://www.pckurier.pl/archiwum/art0.asp?ID= 4846

http://www.pckurier.pl/archiwum/art0.asp?ID= 5453

http://www.networld.pl/news/64905.html

Opis

Protokół SSL (Secure Sockets Layer) pozwala na uwierzytelnienie

stron transmisji oraz zachowanie poufności danych. Najogólniej mówiąc, odpowiada

on za wynegocjowanie parametrów bezpiecznego połączenia z serwerem, a jego

działanie opiera się na tzw. certyfikatach cyfrowych. Same algorytmy szyfrujące

nie są częścią SSL, gdyż jest on wykorzystywany jedynie do określenia, które z

nich mają być użyte do transmisji. Technologia SSL koduje hasła i inne tajne

informacje podczas komunikacji serwera z komputerem użytkownika. Adresy URL

stron internetowych chronionych tym protokołem rozpoczynają się od wyrażenia

"https://", a w trakcie ich ładowania i pobytu na nich, w dolnej ramce

przeglądarki widoczna jest ikona kłódki.

Open source'owa biblioteka OpenSSL jest wykorzystywana jako zestaw narzędzi,

których inne aplikacje używają do zapewnienia kryptograficznej ochrony dla

połączeń sieciowych. Zamiast atakowania OpenSSL bezpośrednio, exploity są

skierowane na aplikacje wykorzystujące OpenSSL.

Aplikacje korzystające z OpenSSL:

- serwer WWW Apache

- sendmail

- pakiet openldap

- CUPS

- serwery POP, IMAP, SMTP i LDAP (wykorzystują odpowiedniki OpenSSL)

Zagrożenia

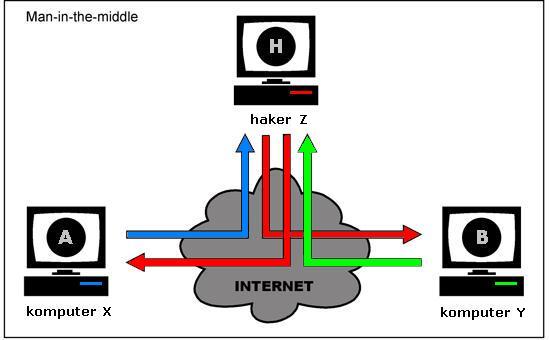

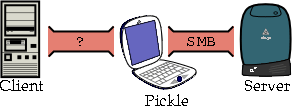

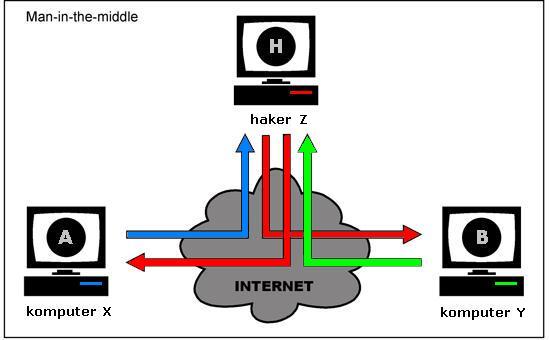

- Man in the middle

Atak polegający na przekierowaniu

ruchu sieciowego do serwera osoby atakującej; następnie ruch ten, po

podsłuchaniu transmisji i zdobyciu np. haseł, jest kierowany z powrotem do

serwera docelowego.

Scenariusz ataku w systemie klucza publicznego:

- X chce połączyć się z Y (np.

stroną banku internetowego). Z jest osobą atakująca

transmisję w celu przechwycenia tajnych haseł X .

- Z w pierwszym etapie musi przekierować ruch z komputera

X do Y na swój komputer, może to zrobić

np. zmieniając dane podawane przez DNS o adresie komputera

Y, lub nasłuchiwać zapytań do DNS i w odpowiednim momencie

wysłać adres swojego komputera. Po połączeniu Z przekazuje

X swój klucz publiczny rzekomo jako klucz publiczny

Y, jednocześnie nawiązuje połączenie z Y,

a otrzymane od niego dane (np. treść strony www) przekazuje

X .

- X widząc stronę logowania Y, wpisuje w

przeglądarce swoje tajne hasło i wysyła je do Z , nie

wiedząc o przechwyceniu transmisji.

- W zależności od celu ataku, Z po odczytaniu hasła albo

przerywa transmisję, albo w dalszym ciągu pośredniczy w transmisji pomiędzy

X i Y , cały czas wykradając tajne dane

(stan konta, dodatkowe hasła itp.).

- W ten sposób Z potrafi odczytać wszystkie przesyłane

pozornie bezpiecznym kanałem dane, nie będąc zmuszonym do czasochonnego

łamania szyfrów zabezpieczających transmisję.

Sytuacja normalna:

X < [Klucz X] --RSA/AES-- [Klucz

Y] > Y

Atak Z:

X < [Klucz X] --RSA/AES-- [Klucz

Z 1] > Z< [Klucz Z 2]--RSA/AES--

[Klucz Y] > Y

- Zbyt krótkie klucze kodowe

Możliwe jest szyfrowanie

danych 128-bitowym kluczem kodowym, niestety nie wszyscy administratorzy

serwisów internetowych korzystają z rozbudowanych możliwości SSL i stosują

"krótsze" klucze. Problem ten dotyczy ok. 18% wszystkich serwisów, które

używają SSL (w Europie 40%). Dzieje się tak dlatego, że klucze o maksymalnej

dostępnej długości w znacznym stopniu obciążają serwery - administratorzy wolą

więc położyć mniejszy nacisk na ochronę przesyłanych danych niż doprowadzić do

przeciążenia serwera.

Źródła:

http://pl.wikipedia.org/

http://www.egospodarka.pl/1095,Dziurawy-SSL,1,12,1.html

http://www.chip.pl/arts/n/sub/article_120062.html

http://www.pckurier.pl/archiwum/art0.asp?ID= 5635

Opis

Kontrola dostępu należy, obok uwierzytelnienia użytkowników, do podstawowych

usług bezpieczeństwa oferowanych przez systemy operacyjne. Warunkiem wstępnym

jest uwierzytelnienie. Uwierzytelniony użytkownik otrzymuje dostęp do tych i

tylko tych obiektów, do których jest upoważniony.

W systemie Unix wszystkie właściwie obiekty są reprezentowane jako "pliki" w

systemie plikowym. Dotyczy to także na przykład aktywnych procesów, gniazd czy

połączeń sieciowych, jak również urządzeń: drukarek, terminali, dysków itp.

Każdy z takich plików posiada nazwę, właściciela, prawa dostępu i inne atrybuty.

Dane te są pamiętane w systemie plików w postaci tzw. i-węzłów (inodes, index

nodes), podstawowej jednostki tworzącej system plików. Jedynie nazwy plików są

zapisane w katalogach i skojarzone z węzłami za pomocą wskaźników.

Przedstawiony sposób obsługi obiektów systemowych powoduje, że zagadnienie

kontroli dostępu do zasobów de facto sprowadza się w Unixie do kontroli dostępu

do plików. Rozróżnia się trzy rodzaje praw dostępu (uprawnień): do odczytu (r,

read), do zapisu (w, write) i do wykonywania (x, execute). Uprawnienia te nadaje

się osobno dla właściciela pliku, członków należących do tej samej grupy, co

plik (nie koniecznie właściciel!), i wreszcie dla wszystkich pozostałych

użytkowników; zapis rwxr-xr-x oznacza pełne prawa właściciela pliku oraz prawo

do odczytu i wykonania (ale nie zapisu) dla wszystkich pozostałych użytkowników.

Superużytkownik - root albo administrator - ma nieograniczone prawa do

wszystkich plików, niezależnie od ustawień praw dostępu.

Niektóre pliki wykonywalne - to jest programy - mogą jednak mieć

inne, zwykle szersze prawa dostępu, niż użytkownik je wywołujący. Jest to

oczywiste - czasami nieuprzywilejowani użytkownicy muszą wykonywać zadania,

które wymagają przywilejów (na przykład polecenie systemowe passwd musi mieć

dostęp do plików systemowych zawierających hasła). Pliki typu SUID (set user id)

oraz SGID (set group id) to pliki wykonywalne, które na czas uruchomienia mogą

przyjąć obcy identyfikator użytkownika lub grupy. Kiedy wykonywany jest program

SUID (lub SGID), jego efektywny identyfikator użytkownika UID (lub grupy GID)

przyjmuje wartość identyfikatora właściciela pliku, a nie uruchamiającego go

użytkownika. Tak więc program SUID, którego właścicielem jest użytkownik root

(czyli tzw. SUID root) może wszystko - ma nieograniczone uprawnienia bez

względu na to, kto go uruchomił.

Zagrożenia

Programy SUID i SGID mogą stanowić poważne zagrożenie bezpieczeństwa systemu.

Nieopatrznie (lub nielegalnie) utworzony program tego typu może dać postronnym

osobom dostęp do chronionych zasobów. Na przykład skopiowanie pliku shella

systemowego (cp /bin/sh super) i nadanie mu uprawnień SUID (np. chmod 4755)

powoduje, że utworzony plik jest wytrychem, pozwalającym na swobodny

dostęp do plików danego użytkownika. W ten sposób na intruz może przejąć

kontrolę na przykład nad plikami superużytkownika root (czyli nad całym systemem

plikowym komputera!).

Zabezpieczenia

Niektóre wersje Unixa obsługują listy kontroli dostępu (ACL - Access

Control Lists). Stanowią one rozszerzenie standardowego systemu uprawnień.

Pozwalają na zdefiniowanie dodatkowych praw dostępu dla poszczególnych

użytkowników lub grup - a nie tylko dla bliżej nieokreślonego ogółu

pozostałych użytkowników. Jeśli na przykład określony użytkownik X ma

współpracownika Y, z którym chciałby dzielić dostęp do określonego pliku, to

przy zastosowaniu ACL może po prostu dołączyć do listy związanej z plikiem

odpowiednie uprawnienia dla Y. Bez list ACL musi się udać do administratora

systemu (superużytkownika), który stworzy grupę użytkowników obejmującą X i Y, a

następnie przepisać plik do tej grupy, jednocześnie ustawiając odpowiednio

atrybuty dostępu do grupy.

Niestety, nie wszystkie systemy Unix zawierają mechanizm ACL; co więcej wśród

tych, które go implementują, nie ma zgody co do tego, jak powinien wyglądać

standard.

Źródła:

http://sun.iinf.polsl.gliwice.pl/~jfrancik/publ/download/bielsko02.pdf

Zalety i wady

Ten rodzaj zabezpieczenia systemu umożliwia ochronę przed

większością exploitów (w szczególności tych opierających swoje działanie na

przepełnieniu bufora). Niestety instalacja łat na jądro powoduje nieznaczny

spadek wydajności działania systemu oraz nieliczne problemy z aplikacjami

takimi jak np. Xfree.

Techniki

-

-

Ochrona stosu metodą stronicowania

-

Ochrona stosu metodą segmentacji

-

Randomizacja adresów (ASLR)

Implementacje

-

OpenWall

http://www.openwall.com/

- ochrona przed większością ataków przepełnienia bufora, ponieważ łata

Openwall czyni stos niewykonywalnym,

- kontrola nad dowiązaniami w katalogach z atrybutem +t (sticky bit),

- kontrola dostępu do /proc, co powoduje, że jedynie uprzywilejowani

użytkownicy mają dostęp do pełnego drzewa procesów,

- restrykcja na kolejki FIFO, co nie pozwala na zapis użytkownikowi, który

nie jest jej właścicielem.

-

GRsecurity

http://www.grsecurity.org/

- zapobiega wykonywaniu kodu w stosie, co komplikuje działanie exploitów i

sprawia że ich stworzenie staje się trudniejsze,

- PaX uniemożliwia wykonywanie niektórych fragmentów pamięci (stos,

sterta), zabezpieczając system skuteczniej niż non-executable stack z

Openwalla,

- ładowany dynamicznie kod, pojawia się pod losowym (a więc nie znanym

włamywaczowi) adresem; praktycznie niemożliwa staje się więc ingerencja w

taki kod,

- uniemożliwia użytkownikom dostęp do plików w /proc które ich nie dotyczą

(informacje o procesach innych użytykoników, sieci, ...),

- zapobiega atakom z użyciem dowiązań poprzez nałożenie pewnych ograniczeń

na system plików,

- deskryptory plików 0 (stdin), 1 (stdout) i 2 (stderr), które mogą zostać

użyte przez włamywacza do odczytu lub zapisu w plikach mu niedostępnych są

zabezpieczane poprzez "wymuszenie" ich otwarcia - jeśli aplikacja ich nie

używa zostaje otwarty /dev/null,

- ogranicza możliwości roota wewnątrz chroot jail; nie będzie on mógł

ładować modułów, korzystać z bespośredniego I/O, zmieniać czasu, rebootować

systemu, itd...,

- umożliwia wybranie dodatkowych zdarzeń, które mają być zapisywane przez

jądro w dzienniku systemowym,

- ograniczenie dostępu do komunikatów wypisywanych przez jądro wyłącznie

do użytkownika root,

- umożliwia wydzielenie (przez dodanie do odpowiedniej grupy),

użytkowników, którzy będą mogli uruchamiać pliki znajdujące się jedynie w

katalogach których właścicielem jest root i tylko on może w nich zapisywać

uniemożliwi to "wybrańcom" uruchomienie nieznanego kodu (np. exploita),

- ograniczanie możliwości tworzenia gniazd sieciowych przez

użytkowników,

-

WOLK (Working Overloaded Linux Kernel) są to stabilne oraz

rozwojowe jądra Linuksa, w których skład wchodzą najważniejsze łaty

niedostępne w standardowej wersji kernela. WOLK ułatwia kompilację jądra -

nie trzeba osobno ściągać i instalować potrzebnych łat. Z drugiej strony,

tak przygotowany kernel jest niestabilny. Ponadto podczas jego konfiguracji

trzeba wybierać spośród wielu niepotrzebnych często opcji. Może się więc

okazać, że najlepszym wyjściem jest, mimo wszystko, samodzielne nałożenie

łat i kompilacja jądra.

Dodatek do GCC

- konieczna rekompilacja ze źródeł

Zabezpieczenie przed nadpisaniem stosu i

sterty

Implementacje

- StackGuard oraz StackShield

Działają na podobnej zasadzie: na stosie umieszczany jest adres

powrotu do procedury i dodatkowe słowo. Jeśli dodatkowe słowo zmieni swą

wartość, oznacza to przepełnienie bufora. Wtedy proces zostaje zatrzymany,

co uniemożliwia dalszą penetrację systemu. Niestety, oba narzędzia są

zdecydowanie przeznaczone dla twórców oprogramowania, a nie użytkowników.

- ProPolice

ProPolice (Stack Smashing Protector) to patch dla popularnego w

linuksie kompilatora "gcc". Uniemożliwia on nadpisania adresu powrotu z

funkcji przez wstawienie wartości kontrolnej, jeżeli zostanie ona zmieniona,

program zostanie zatrzymany. Propolice zmienia również kolejność zmiennych

na stosie w taki sposób, ażeby niemożliwym było nadpisanie wskaźników do

funkcji.

Kontrola dostępu należy, obok uwierzytelnienia użytkowników, do

podstawowych usług bezpieczeństwa oferowanych przez systemy operacyjne.

Warunkiem wstępnym jest uwierzytelnienie. Uwierzytelniony użytkownik otrzymuje

dostęp do tych i tylko tych obiektów, do których jest upoważniony.

Mechanizmy te opierają się na trzech pojęciach:

-

- Podmioty (subject) mają dostęp do obiektów. Np. użytkownik,

terminal, komputer, aplikacja,

- Obiekty (object) są jednostkami, do których kontroluje się

dostęp,

- Prawa dostępu (access rights) określają sposób dostępu podmiotu

do obiektu. Są definiowane dla par (podmiot,

obiekt).

Dostęp uznaniowy DAC (Discretionary Access

Control)

Zestaw procedur i mechanizmów, które realizują kontrolę

dostępu wg uznania użytkownika będącego zwykle właścicielem zasobu. Zapewnia

użytkownikom elastyczność funkcjonowania, zwykle kosztem bezpieczeństwa.

Niektóre zasoby nie są wystarczająco chronione z powodu nieświadomości lub

przeoczenia przez użytkownika. Przykładem rozwiązania typu DAC jest mechanizm

praw dostępu w systemie UNIX. Mechanizm bitów SUID i GUID jest często

wykorzystywany podczas ataku intruza w celu wejścia w prawa użytkownika

root.

Dostęp narzucony MAC (Mandatory Access

Control)

Uprawnienia użytkowników określa administrator systemu.

Umożliwia to zaimplementowanie konsekwentnej polityki ochrony zasobów w całej

sieci. Najczęściej wykorzystywanym mechanizmem są etykiety poziomów zaufania.

Mechanizmy MAC są mniej elastyczne i wręcz przeszkadzają w otwartym

współdzieleniu zasobów przez użytkowników. Mimo to MAC należy do

mechanizmów implementowanych w łatach do systemu UNIX.

-

- ACL (Access Control Lists),

- skanowanie malware,

- jails,

- kontrola zasobów (moduł RES z minimalnymi i maksymalnymi ustawieniami

zasobów dla użytkowników i programów),

- wymuszanie uwierzytelniania,

- Linux Capabilities (np. ukrywanie procesów w module CAP),

- MAC / Bell-LaPadula,

- setuid itp.: powiadomienie jest zawsze wysyłane, nawet jeśli uid został

ustawiony na tę samą wartość; to pozwala osiągnąć właściwą rolę dla

zarezerwowanych ról początkowych po zmianie uid na roota,

- opóźniony init dla ramdysków: opóźnia init RSBAC do chwili, w której

zostanie zamontowane pierwsze urządzenie,

- dodatkowe flagi plików.

NSA Security Enhanced Linux

http://www.nsa.gov/selinux/index.cfm

SELinux został stworzony przez NSA (National Security Agency) w USA i developerów Linuksa. Jest to patch dla kerneli z rodziny 2.4.x i 2.6.x,

ale oprócz tego zawiera także cały zespół łatek dla wielu innych programów (m.in. OpenSSH, coreutils, PAM). Głównym celem twórców SELinux była poprawa

kwestii związanych z dostępem do danych, zabezpieczenie pamięci, w której wykonywane są programy, umożliwienie implementacji biblioteki "libselinux" we

własnym oprogramowaniu i wiele innych zaawansowanych funkcji. Standardowo SELinux zaczyna być dołączany do niektórych dystrybucji Linuksa takich jak Fedora

czy Gentoo, ale wymaga aktywacji i konfiguracji ze strony użytkownika

OpenBSD

http://www.openbsd.org/

Wolnodostępny

system operacyjny typu UNIX z rodziny BSD zgodny z normą POSIX. Projekt

powstał w 1996 roku jako efekt rozłamu w zespole NetBSD, jego inicjatorem był

kanadyjski programista Theo de Raadt.

Chronologia

Pierwsza wersja systemu o numerze 2.0 ukazała się 18 października 1996. 29

października 2004 ukazała się najnowsza aktualnie wersja o numerze 3.6.

Charakterystyka

Nacisk przy tworzeniu systemu został położony przede wszystkim na

bezpieczeństwo. Po rozłamie przyjęty za bazę projektu kod NetBSD został

poddany audytowi w celu wykrycia i usunięcia wszelki dziur i błędów, które

mogłyby zagrozić bezpieczeństwu systemu. Domyślnie wszystkie usługi dostępne w

systemie, a które nie są niezbędne do jego działania, są zdeaktywowane (motto:

Secure by Default). W związku umiejscowieniem siedziby poza USA w początkowej

fazie rozwoju nie dotyczyły go restrykcje eksportowe narzucone na zaawansowane

metody kryptograficzne. Dzięki temu OpenBSD od początku mogło być wyposażone w

takie usługi, jak SSH (wolna wersja OpenSSH) czy SSL (OpenSSL). Dziedzictwo po

NetBSD zaowocowało sporą przenośnością systemu (poszczególne wydania OpenBSD

powstawały na bazie portów NetBSD). Obecnie jest on dostępny dla następujących

platform: i386, SPARC, SPARC64, HP300, Amiga, Mac68k, MacPPC, Mvme68k, Alpha,

VAX. Zarzucone platformy obejmują: Sun3 (do wersji 2.9), ARC, Mvme88k, PMax.

OpenBSD pozwala uruchamiać binaria skompilowane dla następujących systemów:

SVR4, Solaris, FreeBSD, Linux, BSD/OS, SunOS oraz HP-UX.

Zastosowania

Powszechnie stosowany jako system do tworzenia systemów ścian ogniowych

(firewall), serwerów dostępowych czy bramkowych podłączających w bezpieczny

sposób mniejsze sieci do Internetu.

Atak na system komputerowy jest to działanie mające na celu przeniknięcie do chronionego systemu komputerowego

w celu przechwycenia, zniszczenia lub zmodyfikowania przechowywanych tam informacji.

Ataki możemy podzielić ze względu na:

1. Miejsce ich przeprowadzania:

- Zewnętrzne (zdalne) - ataki przeprowadzane są z systemów znajdujących się poza atakowaną siecią

- Wewnętrzne (lokalne) - ataki przeprowadzane są z systemów znajdujących się w atakowanej sieci

2. Zamiar:

- Zamierzony - atakujący zdaje sobie sprawę z tego, co robi i jakie konsekwencje mogą z tego wyniknąć,

na przykład atak w celu uzyskania konkretnie wytyczonych informacji.

- Niezamierzony - atakujący przypadkowo i nieświadomie dokonuje ataku, na przykład jeden z

użytkowników serwera przez błąd programu obchodzi system autoryzacji uzyskując prawa administratora.

3. Aktywność:

- Aktywny - w wyniku ataku system komputerowy traci integralność, na przykład atak włamywacza,

który usuwa pewną ilość ważnych danych oraz powoduje zmianę działania programów. Atakiem aktywnym może

być także modyfikowanie strumienia danych lub tworzenie danych fałszywych.

- Pasywny - atak ten polega na wejściu do systemu bez dokonywania żadnych zmian,

na przykład atak włamywacza, który kopiuje pewną ilość ważnych danych nie powodując zmian w działaniu

programów. Atakiem pasywnym może być także podsłuchiwanie lub monitorowanie przesyłanych danych.

W tym przypadku celem osoby atakującej jest odkrycie zawartości komunikatu.

Ataki pasywne są bardzo trudne do wykrycia, ponieważ nie wiążą się z modyfikacjami jakichkolwiek danych.

4. Przepływ informacji:

- Przerwanie (interruption) - jest atakiem na dyspozycyjność polegającym na częściowym zniszczeniu

systemu lub spowodowaniu jego niedostępności (niezdolności do normalnego użytkowania).

Przykładem tutaj może być fizyczne zniszczenie fragmentu komputera lub sieci, np. uszkodzenie dysku,

przecięcie linii łączności między komputerem a drugim obiektem, lub uniemożliwienie działania systemu

zarządzania plikami.

- Przechwycenie (interception) - jest atakiem opierającym się na poufności i występuje wtedy,

gdy ktoś niepowołany uzyskuje dostęp do zasobów naszego systemu komputerowego. Przykładem tutaj

może być podsłuch pakietów w celu przechwycenia danych w sieci i nielegalne kopiowanie plików lub

programów.

- Modyfikacja (modification) - jest atakiem opierającym się na nienaruszalności polegającym na

zdobyciu dostępu do zasobów przez niepowołaną osobę, która wprowadza do nich jakieś zmiany w celu

uzyskania wyższych praw lub utrzymaniu dostępu do danego systemu. Przykładem tutaj może być zmiana

wartości w pliku z danymi, wprowadzenie zmiany w programie w celu wywołania innego sposobu jego

działania lub modyfikacja komunikatów przesyłanych w sieci.

- Podrobienie (fabrication) - podrobienie jest atakiem opierającym się na autentyczności,

podczas przesyłania danych z jednego do drugiego komputera trzeci komputer blokuje uniemożliwiając

mu dalszy przesył, a sam wprowadza do systemu drugiego komputera fałszywe obiekty.

Przykładem tutaj może być wprowadzenie nieautentycznych komunikatów do sieci lub dodanie danych do pliku.

- Jak UNIX przechowuje hasła?

Każdy system operacyjny przechowuje pewnego rodzaju bazę danych z hasłami, która jest stosowana

do identyfikowania użytkowników podczas logowania. Baza danych systemu UNIX jest zawarta w pliku

/etc/passwd znajdującym się na serwerze. Jednakże ta baza danych nie przechowuje tak naprawdę haseł,

ani nawet haseł zaszyfrowanych, które można potem odszyfrować. Przechowuje jednokierunkową funkcję

haszującą hasła użytkowników.

Jednokierunkowa funkcja haszującą przetwarza dane wejściowe i zapisuje je w postaci unikatowej

wartości. W systemie operacyjnym UNIX hasło podane przez użytkownika jest przedstawiane w postaci

ciągu bajtów, a następnie za pomocą algorytmu jednokierunkowej funkcji haszującej jest przekształcane

w unikatową wartość

Gdy użytkownik próbuje zalogować się do serwera UNIX-owego, wówczas jego terminal przesyła do

serwera żądanie zalogowania w postaci zwykłego tekstu. Serwer z kolei przeprowadza na tym tekście

takie same przekształcenia, jak w wypadku generowania pierwszej wartości funkcji haszującej do bazy

danych z hasłami. Innymi słowy, serwer przeprowadza na podanym haśle operację jednokierunkowego

haszowania. Następnie serwer porównuje wygenerowaną zhaszowaną wartość z wartością znajdującą się

w bazie danych haseł. Jeżeli obie wartości są identyczne, to serwer loguje użytkownika do systemu.

W przeciwieństwie do systemu Windows NT i NetWare, które szyfrują hasło jeszcze przed przesłaniem go do

serwera, system UNIX przesyła nie zaszyfrowane hasło narażając je na wychwycenie przez osoby postronne.

Co gorsza, w przeciwieństwie do systemu Windows NT, który korzysta z Message Digest-4 (MD-4), bardzo silnego

algorytmu szyfrowania, system UNIX korzysta z 8-bitowej funkcji haszującej, dającej w wyniku łatwiejszy do

złamania zestaw haseł. Ze względu na to, że plik haseł jest dostępny domyślnie wszystkim użytkownikom,

a nie ukryty, jak w wypadku systemów Windows NT i NetWare, system UNIX jest znacznie bardziej narażony

na atak brutalny albo atak słownikowy.

- Jak hakerzy łamią hasła?

Aby zdobyć plik z hasłami z sieci UNlX-owej, haker musi mieć dostęp do tej sieci albo przynajmniej

mieć możliwość wykorzystania usług sieciowych do zdobycia dostępu do pliku /etc/passwd.

Po zdobyciu pliku z hasłami haker potrzebuje jeszcze 8-bitowej funkcji szyfrującej używanej w systemie

UNIX. Następnie może on przeprowadzić na pliku z hasłami albo atak brutalny, albo atak słownikowy.

Ponieważ plik /etc/passwd jest dostępny wszystkim użytkownikom na serwerze UNIX, haker może zdobyć

ten plik dysponując minimalnymi prawami dostępu do serwera.

Atak brutalny - metoda ta to najprostszy sposób wyszukiwania tajnych kluczy i haseł.

Polega na wypróbowaniu (podstawianiu) wszystkich możliwych kombinacji znaków w obrębie całej przestrzeni

klucza do momentu jego odnalezienia. Podejście tą metodą może być ogromnie czasochłonne zależnie

od długości hasła i mocy obliczeniowej komputera.

Atak słownikowy - wyszukiwanie słownikowe to szybszy wariant metody brute force. Podstawowym założeniem

tej metody jest przypuszczanie, że do zaszyfrowania tekstu użyto naturalnego słowa (a nie dowolnych

kombinacji liter) pochodzącego z języka, którym włada szyfrujący. Program deszyfrujący podstawia zatem

wyrazy zawarte w dostępnym mu zbiorze (słowniku). Odpowiednie słowniki dla wielu języków można znaleźć w

Internecie. Hackerzy często uzupełniają słowniki o hasła pochodzące z bliskiego otoczenia osoby,

która szyfrowała dany tekst. Do takich wyrazów należą przykładowo imiona członków rodziny czy znajomych,

ksywki, marki samochodów itp.

- Co zrobić?

Utajniać hasła i używać programów zwiększających ich bezpieczeństwo

np. przechowywać hasła w /etc/shadow

Stosować lepsze hasła: minimum 8-znakowe, zawierające cyfry, symbole i litery.

Regularnie zmieniać hasła.

- Więcej o hasłach w linuksie:

http://zgul.ime.uz.zgora.pl/bezpieczenstwo_pdf/network_security.pdf

- Co to jest?

Skaner to program automatycznie wyszukujący luki w systemie. Dobry skaner jest więcej wart niż tysiąc

haseł użytkownika, jest to program, który samodzielnie potrafi wykrywać - nawet na odległość -

słabości sieci oraz serwerów.

Poprzez analizę zainstalowanego oprogramowania i jego konfiguracji, a także przeprowadzanie prób łamania

zabezpieczeń skanery określają, które typy ataków są możliwe do przeprowadzenia, a także podają sposoby

zabezpieczenia się przed nimi.

Skanerów nie należy traktować jako narzędzi, które za nas wszystko załatwią.

One po prostu oszczędzają nam wielu godzin żmudnej pracy. Powinniśmy je wykorzystywać do wstępnego

badania sieci i jej rozpoznania.

- Rodzaje skanerów.

Skanery systemowe.

Skanery systemowe badają host lokalny, poszukują dziur, które wynikły z przeoczeń, problemów przy

konfiguracji i błędów w administracji. Do tego typu luk można zaliczyć błędnie zbudowane identyfikatory

użytkowników, zbyt liberalne prawa dostępu do plików, domyślne konta, słabe hasła i jeszcze parę innych.

Skanery sieciowe.

Skanery sieciowe testują hosty przez łącza sieciowe. Przeszukują dostępne usługi i porty, po prostu

poszukują znanych luk. Rozpoznają więc uruchomione usługi i testują je pod kątem znanych luk w

bezpieczeństwie, które można wykorzystać zdalnie.

- Kto ich używa?

Administrator, aby zwiększyć bezpieczeństwo systemu.

Haker, aby się włamać.

- Co skaner może?

odnaleźć komputer lub sieć

wykryć obsługiwane przez serwer usługi

zdiagnozować je

scharakteryzować system operacyjny

scharakteryzować strukturę sieci komputerowej

- Co więc haker robi?

W pierwszej kolejności wykonuje skanowanie zdalnej maszyny pod kątem

otwartych portów, a następnie próbuje uzyskać informacje o rodzaju i wersji

oprogramowania odpowiedzialnego za obsługę tych portów, a także informacje

o architekturze i systemie operacyjnym.

Większość wykorzystywanych przez hakerów dziur w systemach jest zależna

od oprogramowania zarządającego daną usługą, bądź nawet od wersji całego

systemu. Posiadając już wszelkie informacje, haker może odwiedzając stronę

internetową z listą dostępnych exploitów, ściągnąć z niej odpowiedni program

i przeprowadzić atak.

- Co to jest?

Sniffing jest techniką polegającą na podsłuchiwaniu pakietów przepływających w sieci.

Każdy komputer podłączony do lokalnej sieci komputerowej ma swój własny unikalny adres sprzętowy.

W sieci, w której występuje rozgłaszanie (ang.broadcasting), dane są rozsyłane do wszystkich komputerów,

ale odbierają je tylko te do których są zaadresowane. Wykorzystując fakt, że karty sieciowe w

trybie mieszanym (promiscous mode) pozwalają na odczytywanie pakietów przesyłanych do innych komputerów

w sieci, haker może przechwycić poufne informacje przesyłane poprzez sieć. Programy służące w tym

celu nazywa się snifferami. Zainstalowanie sniffera w jakimś newralgicznym miejscu sieci, np. na

routerze, może doprowadzić do pokonania zabezpieczeń wszystkich innych stacji roboczych z nim połączonych.

Programy tego typu na ogół przechwytują wszystkie pakiety z danymi.

Jeśli haker nie kradnie danych, to z jego punktu widzenia większość pakietów nie ma dla niego większego

znaczenia, dlatego też ogranicza się przechwytywanie do kilkuset bajtów z każdego pakietu.

Zazwyczaj wystarcza to do poznania nazwy użytkownika i jego hasła. Sniffery można zainstalować

praktycznie na każdej maszynie w sieci, ale najbardziej interesujące dla hakera są miejsca,

gdzie dokonuje się procedur autoryzacji.

- Pochodzenie.

Sniffery pierwotnie używane były przez administratorów w celu identyfikacji potencjalnych problemów,

jednakże z czasem zostały zaadaptowane przez hakerów, ponieważ świetnie nadają się do

przechwytywania cennych danych.

- Rodzaje.

Sniffery występują w postaci programów darmowych oraz pakietów komercyjnych.

Te pierwsze są łatwo dostępne, bezpłatne, rozprowadzane głównie w postaci kodu źródłowego.

Drugie są produktami, których cena niejednokrotnie sięga kilku tysięcy dolarów. Dlaczego?

Działający sniffer tak obciąża system, na którym jest zainstalowany, że komercyjne

produkty niejednokrotnie są rozwiązaniami sprzętowoprogramowymi, uwzględniającymi hardware na

którym będą działać oraz funkcję sieciową, jaką będą spełniać.

Oczywiście atutem stosowania komercyjnych rozwiązań jest oferowany przez firmę pełen serwis,

pomoc techniczna, itp. oraz to, że analizują dużą ilość protokołów.

Ze względu na umiejscowienie sniffera w sieci wyróżnić można trzy sytuacje:

1. Sniffer znajduje się na routerze znajdującym się między siecią lokalną a Internetem

(połączenie nie musi być bezpośrednie), bądź też między różnymi sieciami lokalnymi lub rozległymi.

Ten rodzaj sniffingu jest najbardziej niebezpieczny.

2. Sniffer znajduje się na komputerze, z którego inicjowane jest połączenie.

3. Sniffer działa na komputerze, na który następuje próba logowania użytkownika.

- Jak się bronić.

Wykrywanie snifferów w sieci jest zadaniem trudnym, bowiem programy tego typu działają pasywnie

i nie zostawiają żadnych śladów w logach systemowych.

Do znalezienia sniffera na lokalnym komputerze można użyć sum kontrolnych MD5,

oczywiście pod warunkiem, że sam pakiet MD5 został zainstalowany dostatecznie wcześnie,

najlepiej zaraz po instalacji systemu,

a sama baza oryginalnych sum kontrolnych jest fizycznie niedostępna dla hakera.

Jeśli haker podpiął się bezpośrednio do medium transmisyjnego, należy sprawdzić każdy centymetr kabla

sieciowego, bądź też zastosować narzędzia służące do mapowania topologii sieci.

Sniffery przechwytują pakiety wędrujące po medium transmisyjnym, do którego są podpięte.

W związku z tym, podział sieci na mniejsze podsieci zmniejsza ilość informacji,

które mogą być przechwycone. (Sniffery nie potrafią przejść takich

urządzeń jak bridge, switche czy routery). Jest to jednak bardzo kosztowne rozwiązanie.

Idealnym wyjściem jest szyfrowanie danych. Nawet jeśli haker przechwyci pakiety,

to zakodowane informacje w nich zawarte będą dla niego bezużyteczne. Można tu napotkaą problem,

czy metoda szyfrowanej komunikacji jest wspierana przez wszystkie

strony biorące w niej udział, ponieważ szyfrowanie sesji międzyplatformowych jest zjawiskiem dość rzadkim.

Jeśli nie mamy do dyspozycji szyfrowania sesji, należy skorzystać z aplikacji, które oferują

silne dwukierunkowe szyfrowanie danych.

Przykładem może być Secure Shell (SSH), który zastępując standardowego telneta,

przy negocjacji połączenia stosuje algorytm RSA, a po autoryzacji transmisja kodowana jest algorytmem IDEA.

- Co to jest?

Spoofing polega na podszywaniu się pod inny komputer.

Celem jest oszukanie systemów zabezpieczających. Podszywaniem określa się dowolną metodę łamania

zabezpieczeń autoryzacyjnych opartych na adresie lub nazwie hosta. Rodzajami spoofingu jest: ARP spoofing,

DNS spoofing, IP spoofing, Route spoofing, Non-blind i Blind spoofing. Krótko omówię najważniejsze dwa:

IP spoofing (maskarada) - metoda ta polega na podsłuchiwaniu przez sniffer połączenia pomiędzy

klientem a serwerem i wyłapywaniu wysyłanych numerów sekwencji. Po znalezieniu algorytmu jakim są one

tworzone atakujący doprowadza do niestabilności połączenia np. poprzez atak SYN Flood na stacje

klienta, zmienia numer IP na numer klienta i przewidując numery sekwencji korzysta z istniejącego

połączenia jako autoryzowany użytkownik.

DNS spoofing - jest to atak na serwer DNS, który posiada bazę danych przechowującą numery IP

dla poszczególnych adresów mnemonicznych. Atak DNS spoofing polega na ingerencji w tablicę DNS i

modyfikacji poszczególnych wpisów tak, aby klient zamiast do komputera

docelowego kierowany był do komputera atakującego.

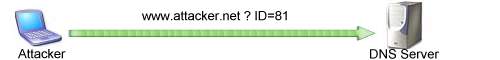

Jak to może wyglądać?

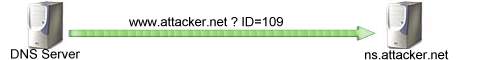

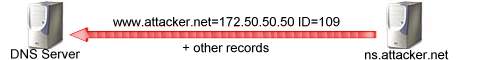

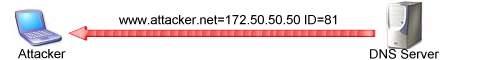

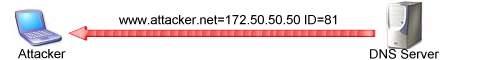

- Serwer DNS nie przechowuje wszystkich adresów IP. Zajmowało by to za dużo pamięci. Posiada cache, który pozwala

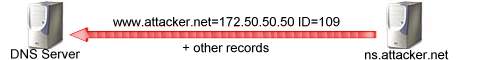

mu trzymac adres IP przez jakiś czas. Jak można "zatruć" serwer DNS? Załóżmy że atakujący ma własną domenę (attacker.net)

i swój własny zhakowany serwer DNS (ns.attacker.net), gdzie umieścił zapis www.cnn.com = 81.81.81.81.

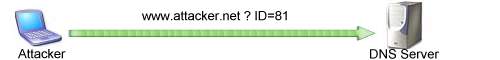

- Atakujący prosi Twój serwer DNS o połączenie z www.attacker.net

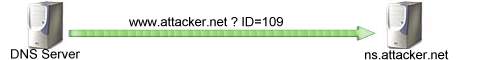

- Twój serwer DNS nie zna tego adresu IP, więc sam o niego pyta.

- Zhakowany serwer odpowiada i jednocześnie "zatruwa" cache

twojego serwera transferując tam swoje zapisy (włączając w to www.cnn.com)

- Twój serwer DNS ma "zatruty" cache.

- Jeśli teraz zechcesz wejść na www.cnn.com twój serwer DNS skieruje cię tam gdzie zażyczył sobie tego atakujący.

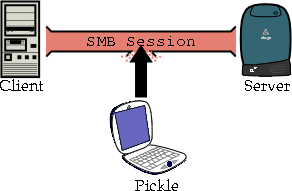

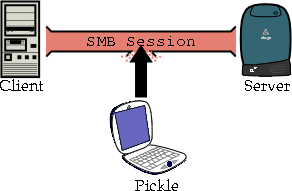

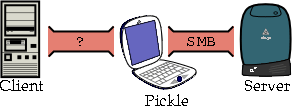

- Co to jest?

Jednym z najbardziej niebezpiecznych ataków na system komputerowy jest

atak polegający na przechwyceniu sesji w protokole TCP (ang. hijacking). Technika

polega na tym, że haker powoduje przerwanie połączenia zestawionego pomiędzy

klientem a serwerem, następnie podszywa się pod klienta i podsyła serwerowi

własne numery sekwencji. Aby mieć możliwość wglądu w przesyłane pakiety,

konieczne jest korzystanie ze sniffera. Hijacking jest więc połączeniem dwóch metod: sniffingu i IPspoofingu.

W celu doprowadzenia do przerwania połączenia TCP należy je wcześniej

rozsynchronizować.

- Rodzaje przerwania połączenia

wczesne rozsynchronizowanie

aktywne rozsynchronizowanie

rozsynchronizowanie pustymi danymi

- Dlaczego jest to gorsze niż spoofing?

Przechwycenie sesji umożliwia hakerowi ominięcie weryfikacji hasła, dzięki czemu

może on bezproblemowo wejść do komputera głównego.

Przechwytywanie w protokole TCP jest dużo większym zagrożeniem niż

podszywanie się pod IP, ponieważ przechwytując już odbywające się połączenie ma

zazwyczaj lepszy dostęp do systemu, nią miałby rozpoczynając je od nowa.

- Wirusy i robaki.

- Cechy charakterystyczne:

powielają się (podstawowy wyróżnik)

wirusy rozprzestrzeniają się poprzez pliki wykonywalne (w tym także np. wygaszacze ekranu,

pliki HTML zawierające kod Javascript lub dokumenty Worda z makrami), dawniej także poprzez

boot-sektory dysków

do uaktywnienia wirusa niezbędne jest uruchomienie zawierającego go pliku;

część wirusów wykorzystuje błędy w oprogramowaniu umożliwiające uruchamianie plików automatycznie

(np. REDLOF, różne robaki pocztowe)

robaki potrafią same rozprzestrzeniać się na inne komputery wykorzystując mechanizmy sieciowe

- Możliwe skutki:

utrudnianie (czasami uniemożliwianie) pracy na komputerze -

w przypadku wielu wirusów jedyny cel

mogą niszczyć, zmieniać dane i/lub oprogramowanie zawarte na dysku

mogą wykradać dane

mogą przenosić i instalować inne typy złośliwych programów, np. konie trojańskie

istnieją (bardzo rzadkie) wirusy mogące uszkodzić komputer - np. CIH (Czernobyl) -

kasowanie pamięci Flash

- Konie trojańskie

- Cechy charakterystyczne:

nie powielają się samoczynnie (ale mogą być roznoszone przez wirusy)

udają programy użytkowe, narzędziowe, gry (stąd nazwa)

końmi trojańskimi mogą być także np. strony WWW zawierające odpowiednio

spreparowane kontrolki ActiveX

zazwyczaj ukrywają się w systemie, tak aby ich działania były trudno zauważalne

często umożliwiają dostęp z zewnątrz do komputera bez wiedzy użytkownika

- Możliwe skutki:

mogą umożliwiać innym osobom manipulowanie komputerem i znajdującymi się na

nim danymi bez wiedzy użytkownika

mogą wykradać dane, przechwytywać obraz z ekranu, tekst pisany na klawiaturze

mogą wykorzystywać komputer do rozsyłania spamu lub zdalnych ataków na inne komputery

mogą pobierać z sieci i instalować inne konie trojańskie lub spyware

dialery mogą narazić użytkowników modemów na wysokie koszty

- Spyware

- Cechy charakterystyczne:

zawarte w oficjalnych wersjach instalacyjnych wielu różnych "darmowych" programów !!! (np. KaZaA)

pojawiają się także w postaci kontrolek ActiveX na stronach WWW (np. Gator - "Precision Time")

podstawowy i jedyny cel - szpiegowanie użytkownika

(informacja o odwiedzanych stronach WWW, ściąganych plikach itp. - zazwyczaj anonimowa,

ale niektóre programy mogą przesyłać dane personalne)

obecność w programie okienek reklamowych może świadczyć o obecności spyware

trudne do odinstalowania, nawet po odinstalowaniu programu - "nosiciela" pozostają w systemie

skutkiem ubocznym może być nieprawidłowe działanie innych programów

zazwyczaj niewykrywane przez programy antywirusowe; niezbędne specjalne programy do wykrywania i

usuwania spyware (np. Ad-Aware, Spybot Search & Destroy)

programy użytkowe zawierające spyware często nie działają po jego usunięciu

funkcje szpiegowskie pełnią czasem także reklamy na stronach WWW

- Profilaktyka i zwalczanie

- Co instalować?

aktualne poprawki do systemu operacyjnego

programy antywirusowe

programy anty-spyware

firewall

- Czego nie robić?

NIGDY nie otwierać załączników w listach, jeżeli z TREŚCI listu nie wynika wyraźnie,

co i po co jest w załączniku (niezależnie od adresu nadawcy - wirusy fałszują adresy!) -

w razie jakichkolwiek wątpliwości upewnić się u nadawcy listu!

NIGDY nie zgadzać się na automatyczną instalację żadnych programów (kontrolek) ze stron WWW,

jeżeli na danej stronie nie ma wyraźnej informacji o zastosowaniu i przeznaczeniu danej kontrolki!

nie klikać na żadne odsyłacze w listach pochodzących od nieznanych nadawców i o "dziwnej" treści

ściągać programy z Internetu tylko z "pewnego źródła", najlepiej ze stron producentów

lub z wiarygodnych, znanych serwisów - nie z przypadkowych stron prywatnych

ustawić odpowiednio poziomy zabezpieczeń w przeglądarce (w IE co najmniej "poziom średni")

używać innej przeglądarki i programu pocztowego zamiast IE i OE (wirusy, robaki itp.

wykorzystują błędy w tych programach)

- Co to jest?

W ogólnym znaczeniu metoda ta polega na częściowym lub całkowitym zablokowaniu dostępu do świadczonych usług.

Podatność ośrodków sieciowych na ataki DoS wynika z ograniczenia zasobów każdego serwera/systemu.

W przypadku zastosowań WWW ograniczenie to wynika przede wszystkim z przepustowości łącza.

Ale nie tylko, innymi ograniczeniami są pamięć operacyjna oraz moc obliczeniowa warunkowana rodzajem stosowanego

procesora (procesorów). Celem i konsekwencją ataku DDoS jest uniemożliwienie systemowi świadczenia usług, co osiąga

się przez zajęcie jego zasobów "czymś innym".

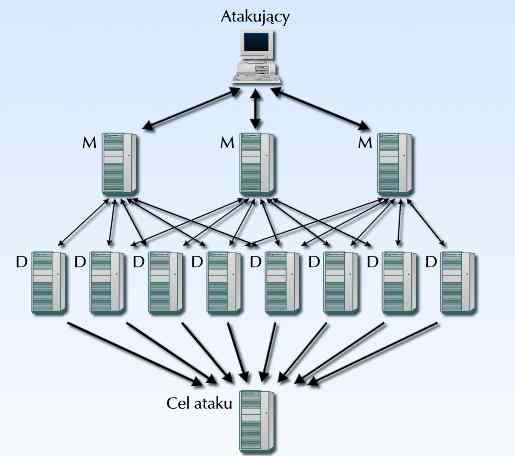

- DOS i DDOS

Atak DoS ma dwa zasadnicze ograniczenia.

Po pierwsze przeprowadzany jest z pojedynczego komputera,

którego łącze internetowe może mieć lub ma zbyt małą przepustowość w stosunku do łącza ofiary.

Po drugie prowadząc atak z jednego komputera, atakujący naraża się na szybsze wykrycie.

Dlatego atak DoS przeprowadzany jest najczęściej na mniejsze serwery zawierające strony WWW.

Atak na większy cel, na przykład portal lub serwer DNS, wymaga zastosowania bardziej wyrafinowanej metody -

DDoS, czyli rozproszonego ataku DoS, opracowanego jako remedium na ograniczenia DoS.

Metoda DDoS jest ukierunkowana na wykorzystanie błędów w stosach protokołu TCP/IP,

natomiast ataki DoS wykorzystują charakterystyczne luki znanych pakietów oprogramowania.

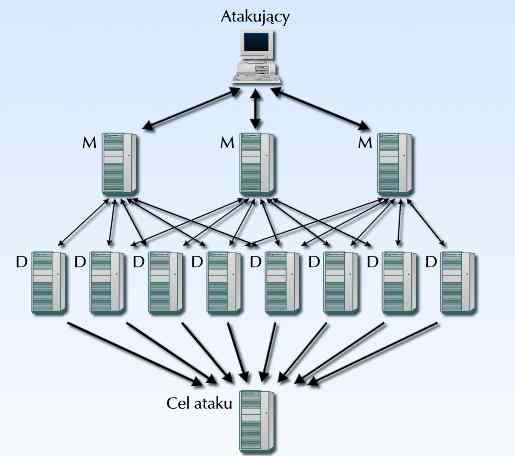

Sieci DDoS składają się z trzech elementów:

Attacker (atakujący, zwany też klientem) maszyna, z której rozpoczyna się atak;

Master (zwany również Handler) serwer, na który włamał się haker i umieścił odpowiednie oprogramowanie

pozwalające na kontrolowanie deamonów; każdy master może obsługiwać wiele deamonów;

Deamon (zwany również agentem) serwer, na który włamał się haker i zainstalował oprogramowanie do

generowania potoku pakietów (packet stream); deamon oczekuje na rozkazy od swojego mastera;

Niektóre implementacje dopuszczają zmianę swojego mastera.

- Przykłady ataków:

SYN Flood

- Napastnik wysyła bardzo dużo pakietów SYN do ofiary

- Atakowany komputer dla każdego nadchodzącego pakietu SYN próbuje utworzyć połączenie

- Powstają "pół-otwarte" połączenia (half-open):czekają na odpowiedź od napastnika,

która jednak nigdy nie nadejdzie

- Powoduje to poważne spowolnienie albo całkowite zablokowanie ofiary

Land

- Napastnik wysyła pakiet ACK zawierający sfałszowany adres źródłowy równy adresowi docelowemu

- Atakowany host usiłuje nawiązać połączenie z samym obą

- Powoduje to zawieszenie maszyny

Teardrop

- Błąd w implementacji stosu TCP/IP, występował zarówno w systemach Windows,

jak i Linux/Unix

- System nie radził sobie z pofragmentowanymi pakietami

- Odpowiednio spreparowane i pofragmentowane pakiety, przy łączeniu w całość, powodowały

nadpisanie jądra systemu

- Firewalle bezradne: albo przepuszczały zabójcze pakiety, albo same się wykładały

- Jak się bronić?

Nie ma uniwersalnej i skutecznej metody chroniącej sieć przed opisywanymi tu zagrożeniami. Zasadniczą przyczyną,

dla której ataki DoS i DDoS są tak trudne do opanowania, jest olbrzymia liczba komputerów źle lub w ogóle niezabezpieczonych.

Są to głównie systemy pracujące na uczelniach :) oraz komputery domowe podpięte na stałe do Internetu.

Ataki tego typu należy traktować bardzo poważnie, ponieważ programy

do blokowania usług są ogólnodstępne, a ich użycie niezwykle łatwe.

- Co to jest?

Przepełnienie bufora (ang. buffer overflow) polega na podaniu programowi większej liczby danych,

niż to przewidział twórca programu. Nadmiarowe dane przekraczają obszar pamięci,

który został przeznaczony dla danych, a tym samym wkraczają w obszar pamięci, który był

przeznaczony na instrukcje programu. W idealnej wersji tego ataku nadmiarowe dane są

nowymi instrukcjami, które umożliwiają napastnikowi sterowanie pracą procesora.

- Skąd się wzięło?

Możliwość przepełniania bufora bierze się z wrodzonej słabości języka C++. Problem,

który został odziedziczony z języka C i który dotyczy również innych języków programowania,

takich jak Fortran, polega na tym, że C++ nie kontroluje automatycznie długości

podawanych programowi danych.

- Przykład.

#include

#include

#include

void bigmac(char *p);

int main(int argc, char *argv[]){

bigmac("Could you supersize that please?");

return 0;

}

void bigmac(char *p)

{

char stomach[10];

strcpy(stomach, p);

printf(stomach);

}

Kompilacja przebiegnie bez przeszkód, ale wykonywanie uruchomionego programu

załamie się. Co się stało? Po uruchomieniu programu, funkcji bigmac przekazywany jest długi łańcuch

znaków. Niestety funkcja strcpy() nie sprawdza

długości kopiowanych łańcuchów. Jest to bardzo niebezpieczne, gdyż przekazanie funkcji

łańcucha o długości większej niż dziewięć znaków powoduje przepełnienie bufora.

Funkcja strcpy(), podobnie jak kilka innych funkcji języka C++, ma istotną wadę, która

powoduje, że nadmiarowe znaki są wpisywane do obszaru pamięci leżącego poza

zmienną. Z reguły powoduje to załamanie się programu. W tym konkretnym przypadku

załamanie programu spowodowała próba czytania poza granicą statycznego łańcucha.

W najgorszym przypadku tego rodzaju przepełnienie umożliwia wykonanie w zaatakowanym

systemie dowolnego kodu.

- Jak haker zabiera się za atak?

Najpierw musi znaleźć działający program, który jest podatny na przepełnienie bufora. Nawet

gdy działanie hakera nie zakończy się uruchomieniem szkodliwego kodu, z pewnością

doprowadzi do załamania programu. Haker musi też znać dokładny rozmiar bufora,

który będzie chciał przepełnić.

Drugim etapem ataku przepełnienia bufora jest wykonanie dostarczonego kodu (ładunku).

Ładunkiem jest zwykle polecenie umożliwiające zdalny dostęp do zaatakowanego

komputera lub inne polecenie ułatwiające hakerowi przejęcie komputera.

Przeprowadzenie skutecznego ataku przepełnienia bufora jest trudne. Jednak nawet wtedy,

gdy atak przepełnienia bufora nie powiedzie się do końca, najczęściej i tak spowoduje

problemy w atakowanym komputerze. Zwykle polegają one na załamaniu się działania

zaatakowanego programu lub nawet całego systemu.

- Jak się bronić.

Najlepszym sposobem, by uniemożliwic ataki przepełnienia bufora, jest przestrzeganie

przez programistę właściwych praktyk programowania. Należą do nich:

- sprawdzanie wielkości danych przed umieszczeniem ich w buforze,

- użycie funkcji ograniczających liczbę i (lub) format wprowadzanych znaków,

- unikanie niebezpiecznych funkcji języka C, takich jak scanf( ), strcpy( ),

strcat( ), getwd( ), gets( ), strcmp( ), sprintf( ).

Istnieją narzędzia, których zadaniem jest badanie podatności kodu na przepełnienie bufora.

Jednym z komercyjnych programów służących do tego celu jest PolySpace (http://www.polyspace.com),

zawierający narzędzie do wykrywania w czasie kompilacji możliwości

przepełnienia bufora w programach napisanych w ANSI C.

Dla Linuksa dostępne są dodatki do kompilatora C++ oraz biblioteki, które sprawdzają

w czasie wykonywania się programu wielkość wprowadzanych danych. Przykładem tego

może byc StackGuard (http://immunix.org), który wykrywa ataki uderzenia w stos,

chroniąc przed zmianą adres powrotu funkcji. Podczas wywołania funkcji umieszcza on

obok adresu powrotu bajty przynęty, natomiast podczas kończenia pracy funkcji

sprawdza, czy przynęta została zmieniona. Jeżeli tak się stało, umieszcza zapis w dzienniku

zdarzeń systemu i kończy działanie programu.

Dodatkową linię obrony mogą stanowić narzędzia kontrolujące rozmiar danych.

Do narzędzi tego typu należą BOWall, Boundschecker firmy Compuware czy Purify firmy Rational.

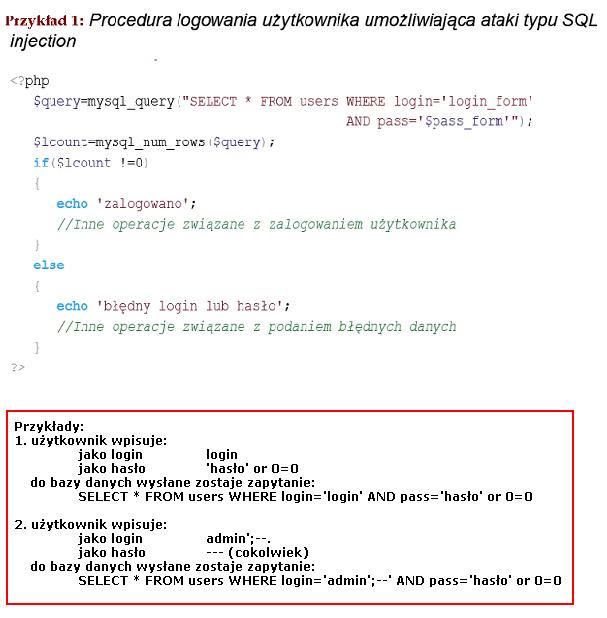

- Co to jest?

SQL injection to typ ataku, który korzysta z dziur w aplikacjach Web'owych.

Wykorzystuje wywołanie zapytania SQL w aplikacji w której nie przetwarza się danych uzyskanych od

użytkownika. Najczęściej polega na takim skonstruowaniu formuły w klauzuli WHERE zapytania,

by sprawdzanie wprowadzonych danych nie miało znaczenia.

- Przykłady:

$login = Request.Form("login")

$password = Request.Form("password")

$query = 'SELECT $field FROM $database WHERE Login=' . $login .'AND Password= '. $password . ';';

logując się do systemu podajmy następujące hasło:

test'or'1=1

w naszym skrypcie php otrzymujemy zapytanie:

SELECT ...

WHERE login='x' AND password='test'or'1=1'

Równie łatwo jest wykorzystać błąd w niecnych celach:

Login: x';DROP TABLE users;--

- Jak unikać?

filtrować dane z wejścia

zwracać uwagę na kluczowe słowa ( SELECT, DROP, TABLE, itd)

zwracać uwagę na kluczowe znaki (cudzysłów, apostrof, itd)

źródła:

- ftp://ftp.helion.pl/online/strada/strada-5.pdf

- http://emkay.spymac.net/publikacje/podrecznik_administratora.pdf

- http://zgul.ime.uz.zgora.pl/pszostak/publikacje.html

- http://inet4u.esol.pl/opatou-dos.pdf

- http://zgul.ime.uz.zgora.pl/bezpieczenstwo_pdf/network_security.pdf

- http://stud.wsi.edu.pl/~dratewka/

- http://www.pckurier.pl/archiwum/art0.asp?ID=6067

- http://www.pckurier.pl/archiwum/art0.asp?ID=3873

W czasach, gdy powstawała sieć Internet, jej twórcy zaprojektowali ją w ten sposób, by była odporna na awarie typu odłączenie

pojedynczych składników sieci, uszkodzenia okablowania, bądź też wahania zasilania. Niestety w tamtych zamierzchłych już

czasach nie przewidziano dodatkowych zabezpieczeń chroniących zasoby prywatne użytkowników Internetu i sieci lokalne

przedsiębiorstw przed atakami z Internetu, bądź też z wnętrza samej sieci lokalnej. Obecnie wraz ze wzrostem popularności Internetu

i liczby jego użytkowników, znacznie wzrosło niebezpieczeństwo utraty prywatności w wewnętrznych sieciach i zagrożenie przeprowadzania ataku na tą sieć

przeprowadzone z Internetu, w celu np. wykradzenia danych lub ich uszkodzenia. Dlatego konieczne stało się zabezpieczanie sieci przed wtargnięciem do niej

osób niepowołanych. Najbardziej skutecznym rozwiązaniem tego problemu byłoby fizyczne odseparowanie wszystkich komputerów realizujących istotne zadania i

przechowujących ważne informacje, lecz oznaczałoby to kompleksową przebudowę całej sieci lokalnej. Rozwiązaniem tego problemu jest zastosowanie

urządzenia zwanego "ścianą ognia" (z ang. firewall, w Polsce często też używa się określenia zapora) chroniącego system lokalny przed ingerencją zewnętrzną.

Firewall jest to zwykle dedykowana maszyna, sprzętowa lub software'owa, która znajduje się między siecią prywatną, a publiczną (z reguły Internetem). Maszyna ta sprawdza każdy

przepływający przez nią pakiet i albo go przepuszcza albo blokuje w zależności od ustalonych przez administratora reguł. Firewalle umożliwiają utworzenie

konfiguracji stanowiącej kompromis pomiędzy siecią prywatną całkowicie izolowaną od publicznej (Internetu), a siecią prywatną swobodnie do publicznej

podłączoną. Umieszczony na styku sieci prywatnej i publicznej, firewall stanowi prosty mechanizm kontroli ilości i rodzaju ruchu sieciowego między obiema

sieciami. Konfiguracja firewalla z reguły może być opisana poprzez następującą politykę bezpieczeństwa: "co nie jest wyraźnie dozwolone, jest zabronione".

Firewalle czasami stosuje się również wewnątrz sieci prywatnych, aby zabezpieczyć istotne elementy przed własnymi użytkownikami (np. dwa działy w jednej

firmie nie powinny mieć dostępu do swoich informacji). Takie rozwiązanie jest korzystne również dlatego, że jeżeli napastnik włamie się do jednej grupy

komputerów to i tak nie będzie miał dostępu do pozostałych komputerów.

Są dwie różne idee projektowania firewalli. Pierwsza to tzw. "czarna skrzynka" - głównie sprzętowe firewalle produkowane przez komercyjne firmy. Ich

sposób działania nie jest bliżej znany. Mamy jedynie dostęp do ich interfejsu użytkownika i ułatwieniach w ich sterowaniu, ale nie mamy pewności czy nie

mają one jakichś luk w bezpieczeństwie, bądź nieudokumentowanych obejść. Druga koncepcja to tzw. "kryształowa skrzynka" - zasady filtrowania pakietów są

ogólno dostępne, ponieważ mamy możliwość obejrzenia kodu źródłowego wraz z jego kompletną dokumentacją. Pozwala to na dokładne sprawdzenie całego kodu

i własnoręczne wprowadzenie ewentualnych poprawek. Firewalle tego typu mają ogromne znaczenie w przypadku, gdy udostępniony jest kod źródłowy całego

systemu operacyjnego, gdyż możemy dostosować konfigurację firewalla do ewentualnych niedociągnięć w samym kodzie systemu.

Żeby dokładniej poznać budowę, sposób działania i typy firewalli, musimy najpierw poznać w jaki sposób komputery komunikują się ze sobą, czyli model OSI (Open System Interconnection) -

standard opisujący strukturę komunikacji sieciowej, zdefiniowany przez organizacje ISO i ITU-T. OSI traktowany jest jako model odniesienia dla większości

rodzin protokołów komunikacji. Podstawowym założeniem tego modelu jest podział na 7 całkowicie niezależnych warstw (ang. layers). OSI definuje jakie zadania

i rodzaje informacji mogą być przesyłane między warstwami w całkowitym oderwaniu od ich fizycznej i algorytmicznej realizacji. Żadna z warstw sama w sobie

nie jest jeszcze funkcjonalna, ale możliwe jest projektowanie warstwy w całkowitym oderwaniu od pozostałych, po uprzednim zdefinowaniu protokołów wymiany

informacji między poszczególnymi warstwami. W modelu OSI wyróżniamy trzy warstwy górne: aplikacji, prezentacji i sesji. Tworzą one interfejs, który pozwala

na współpracę z programistą oraz niższymi warstwami, w zależności od kierunku przepływu informacji. Warstwy dolne to warstwa transportowa, sieciowa, łącza danych i fizyczna.

Odpowiadają one za odnajdywanie odpowiedniej drogi do celu, gdzie ma trafić informacja, weryfikują ich bezbłędność, dzielą informacje na pakiety odpowiednie

dla urządzeń sieciowych. W warstwie dolnej ignorowany jest sens samej informacji. Dla Internetu zdefiniowano uproszczony model DoD (z ang. Department of Defence - Departament

Obrony USA - twórca Arpanet, przodka sieci Internet). Składa się on tylko z 4 warstw. Na poniższym rysunku widzimy porównanie obu modeli: OSI i DoD

A teraz po kolei omówimy kolejne warstwy modelu DoD, gdyż są one dość ważne do zrozumienia działania poszczególnych rodzajów firewalli. Na model DoD składają

się następujące warstwy:

- Warstwa aplikacji - najwyższy poziom, w którym pracują użyteczne aplikacje jak np. serwer WWW, przeglądarka internetowa. Jest to zestaw gotowych protokołów, które te aplikacje

wykorzystują do przesyłania informacji w sieci. Przykładowe protokoły z tej warstwy to: FTP, HTTP, HTTPS, SMTP, Telnet, SSH.

- Warstwa transportowa - zapewnia pewność przesyłania danych i kieruje informacje do odpowiednich dla nich aplikacji. Opiera się to na wykorzystywaniu portów

określonych dla każdego rodzaju połączenia. Każda usługa w Internecie ma przypisany swój własny port, np. dla FTP jest to port 21, dla HTTP port 80. Porty ponumerowane są

liczbami od 1 do 655325. Dzięki takiemu rozwiązaniu w jednym komputerze może istnieć wiele aplikacji wymieniających dane z tym samym komputerem w sieci i nie nastąpi wymieszanie się

przesyłanych przez nie danych. Warstwa transportowa również nawiązuje i zrywa połączenia między komputerami. Protokoły działające w tej warstwie to np.: TCP, UDP, SSL, NetBEUI.

- Warstwa sieciowa - to podstawowa dla działania Internetu warstwa. W niej przetwarzane są pakiety posiadające adres IP. Na jego podstawie ustalana jest odpowiednia

droga do docelowego komputera w sieci. Urządzenia takie jak np. rutery i switche pracują właśnie w tej warstwie, gdyż zajmują się kierowaniem ruchu w Internecie na

podstawie znajomości topologii sieci. Proces znajdowania drogi przez ruter nazywa się routingiem. W tej wartwie działają następujące przykładowe protokoły/urządzenia: IP, ICMP, NAT, NetBEUI.

- Warstwa dostępu do sieci - najniższa warstwa, zajmująca się przekazywaniem danych przez fizyczne połączenia między urządzeniami sieciowymi.

Z reguły są to karty sieciowe lub modemy. Dodatkowo czasem warstwa ta jest wyposażona w dodatkowe protokoły do dynamicznego określania adresów IP. W warstwie tej działają np. następujące protokoły:

802.11 WiFi, ADSL, ISDN, V.90, Token Ring, 10BASE-T, Ethernet.

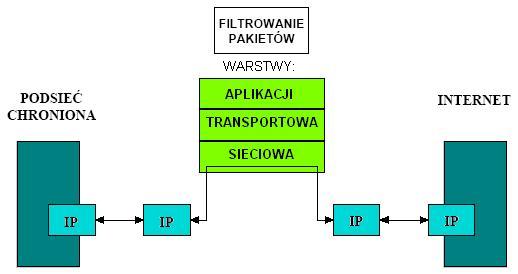

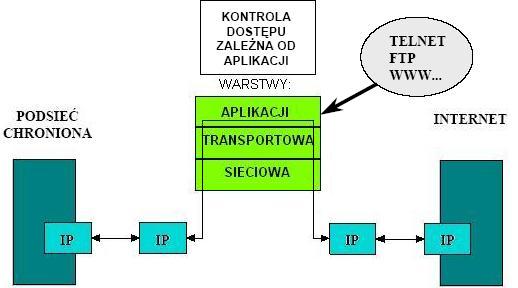

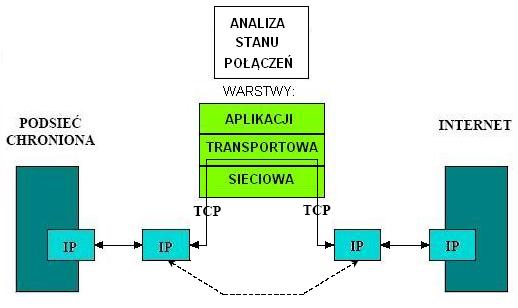

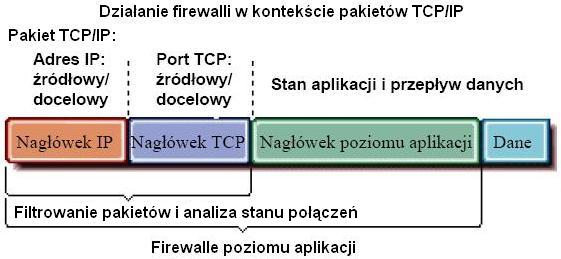

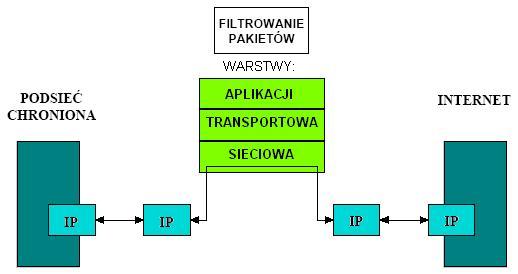

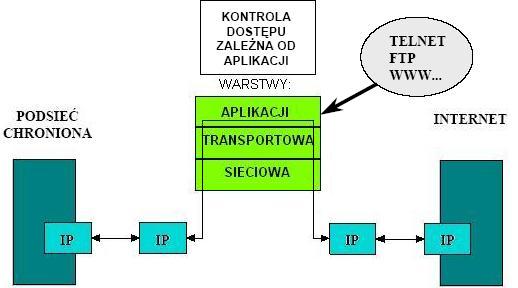

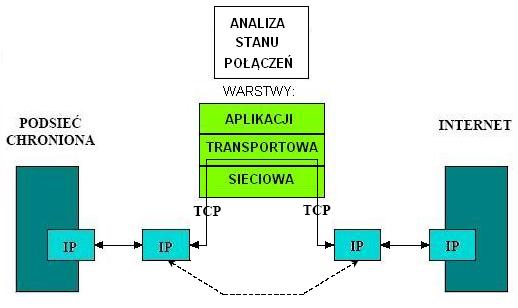

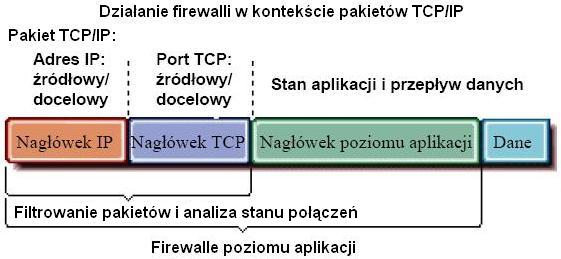

Istnieją trzy typy firewalli, różniące się między sobą tym, w której warstwie modelu OSI kontrolowana jest komunikacja między sieciami:

- filtrowanie pakietów (packet filtering) - działa w warstwie sieci

- analiza stanu połączeń (circuit level firewall) - działa w warstwie transportu

- firewall poziomu aplikacji (application level firewall) - działa na poziomie aplikacji

|

Filtrowanie pakietów:

Ten rodzaj firewalla to z reguły ruter filtrujący (screening router) lub specjalny komputer.

Na podstawie adresu źródłowego i docelowego oraz portu pojedynczego pakietu decyduje on, czy dana przesyłka może zostać przesłana dalej do sieci lokalnej, czy też powinna zostać zatrzymana.

Firewall na poziomie sieci można na przykład skonfigurować tak, by blokował wszystkie wiadomości pochodzące od oraz wysyłane do określonej konkurencyjnej

firmy. Firewall tego typu blokuje lub zezwala na komunikację z siecią chronioną stosując filtr w formie listy kontroli dostępu ACL (ang. Access Control List).

Jest to lista zawierająca zbiór zasad i odpowiadających im akcji zapisanych w określonym porządku, mających na celu podjęcie decyzji czy dany pakiet jest

dozwolony czy nie.

Firewalle stosujące technikę filtrowania pakietów są zwykle bardzo szybkie, jednak głównym ich ograniczeniem jest to, że pracują one tylko w warstwie

sieciowej i łącza danych. Zapewnia im to dostęp tylko do adresów IP,

numerów portów oraz znaczników TCP, nie mają zaś dostępu do informacji o kontekście konkretnego pakietu, co jest niewystarczające dla niektórych usług

internetowych. Poza tym nie są w stanie filtrować danych

przesyłanych za pomocą protokołu UDP (User Datagram Protocol - protokół przesyłania datagramów). Poza tym że większość firewalli tego typu, przede wszystkim

rutery, nie posiada mechanizmów kontrolnych, ani ostrzegawczych o zatrzymanych pakietach. Firewall może zatem odeprzeć wiele ataków, nie informując nawet o

tym administratora sieci. Ponadto często wystarczy

zmienić adres nadawcy pakietu, aby obejść tego rodzaju zabezpieczenie i filtr pakietowy jest już bezradny. |  |

| Firewall poziomu aplikacji:

Firewalle poziomu aplikacji to hosty, na których

uruchomiono serwery proxy. Nie pozwalają one na bezpośredni ruch pakietów pomiędzy sieciami, a także rejestrują i śledzą cały ruch przechodzący przez

nie. Dla każdej aplikacji (czyli usługi sieciowej, np. HTTP, FTP, telnet, SMTP, POP3, etc.)

istnieje osobny proxy, dla którego definiowane są reguły według których podejmowana jest decyzja o

zaakceptowaniu bądź odrzuceniu połączenia. Proxy serwery potrafią więc niejako odseparować wiarygodną część sieci od podejrzanej. Poza tym mogą

magazynować najczęściej żądane informacje - klient kieruje swoje żądanie do proxy, który jeśli wyszuka obiekt w swoich lokalnych

zasobach to zwraca zamawiającemu bez potrzeby komunikacji z siecią zewnętrzną. Tak więc proxy serwer jest też rodzajem cache'u. Niewątpliwym minusem

tego rozwiązania jest konieczność

stosowania wielu serwerów proxy do obsługi różnych aplikacji (usług sieciowych). Jeżeli dla danej usługi nie jest dostępny odpowiedni

proxy serwer, to dane przesyłane w tym formacie nie będą w ogóle przepuszczane przez bramkę.

Firewalle na poziomie aplikacji umożliwiają kontrolowanie typu i objętości danych napływających do sieci lokalnej. Fizycznie oddzielają one sieć

lokalną od publicznej, dzięki czemu dobrze pełnią funkcje ochronne. Ponieważ jednak program musi kontrolować pakiety i decydować o ich przepuszczaniu,

ten typ zapory ogniowej działa wolniej niż zapora ogniowa na poziomie sieci. Jeśli więc jest planowane użycie tego typu zabezpieczenia, to należy

je umieścić w najszybszym komputerze. |  |

| Analiza stanu połączeń:

Zwane również firewallami typu stateful inspection. Firewalle tego rodzaju są rozwiązaniem kompromisowym między szybkością firewalli

filtrujących pakiety, a bezpieczeństwem firewalli poziomu aplikacji. Firewalle te filtrują poszczególne pakiety, jednak nie tylko na podstawie ich nagłówków, tak

jak w zwykłym filtrowaniu pakietów. Firewalle tego typu potrafią przyporządkowywać pakiety do istniejących

połączeń TCP i dzięki temu kontrolować całą transmisję (zaawansowane systemy potrafią także kojarzyć pakiety protokołu UDP, który w

rzeczywistości kontroli połączeń nie posiada). Technika ta zwana jest TCP tunnelingiem i odbywa się bez kontroli zawartości pakietów. Firewalle te na bieżąco śledzą i analizują przechodzące przez nie połączenia,

co pozwala na znacznie skuteczniejsze kontrolowanie ich zgodności z regułami. Z tych powodów często zapory tego rodzaju są również określane pojęciem dynamicznego

filtrowania pakietów. Firewall cały czas przechowuje w pamięci informacje na temat aktualnego stanu

każdego połączenia, a jednocześnie wie jakie kolejne stany tego połączenia są dozwolone z punktu widzenia protokołu i polityki bezpieczeństwa. Administrator

sieci określa tylko kierunek i politykę względem rozpoczęcia danego połączenia, firewall zaś automatycznie weryfikuje kolejne etapy jego

nawiązywania oraz późniejszy przebieg. Ostatnia cecha pozwala również na odrzucanie pakietów, które do danej sesji nie należą, dzięki czemu firewalle te

skutecznie blokują próby skanowania portów lub wprowadzania sfałszowanych pakietów (ang. spoofing). |  |

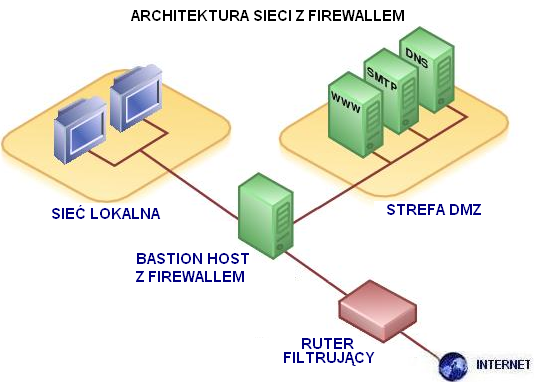

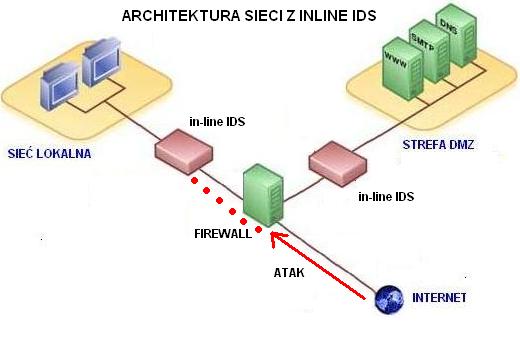

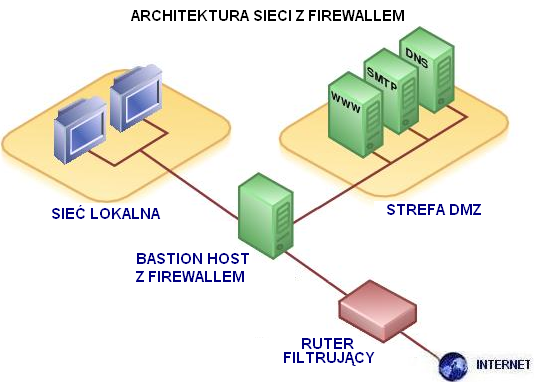

Z reguły sieć lokalna zbudowana w architekturze z firewallem składa się z następujących charakterystycznych elementów:

- Ruter ekranujący

Ruter ekranujący z reguły stanowi pierwszą linię obrony sieci. Dzięki temu, że filtruje on pakiety w warstwie sieciowej, niezależnie od warstwy aplikacji,

nie wymaga wprowadzania zmian do żadnej z aplikacji typu klient czy serwer. Rutery są wygodne w obsłudze i stosunkowo niedrogie, jednak nie są wydajnymi

zabezpieczeniami. Dzięki temu, że pracują one wyłącznie w warstwie sieciowej i łącza danych modelu OSI, są to urządzenia nieskomplikowane w

obsłudze, ale z tego powodu ich możliwości są niewystarczające.

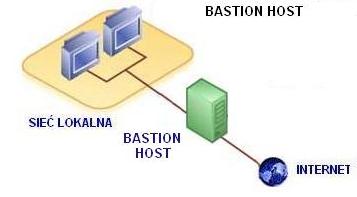

- Bastion host

Następnym punktem obrony sieci jest tzw. bastion host, czyli komputer-bastion lub komputer-twierdza. Nazwa ta wywodzi się ze średniowiecznego terminu

określającego ufortyfikowane miejsce służące do odpierania ataków, np. mury obronne. Analogicznie więc, komputer-bastion jest to komputer stojący pomiędzy

siecią lokalną, a publiczną, wyposażony w specjalne zabezpieczenia chroniące go, jak i całą sieć lokalną przed atakami dokonywanymi z sieci zewnętrznej.

Na komputerze-twierdzy uruchomiony jest z reguły firewall poziomu aplikacji (wariant najbezpieczniejszy) wyposażony w serwery proxy używanych w sieci lokalnej usług internetowych.

Jest on więc kolejnym sitem, przepuszczającym pakiety, jednak tym razem już na poziomie aplikacji, czyli analizujący pakiety w kontekście danej usługi internetowej.

Dzięki scentralizowaniu dróg dostępu w jednym komputerze łatwo można zarządzać systemem ochrony sieci oraz konfigurować odpowiednie

aplikacje dla tego pojedynczego komputera.

- Obszary ryzyka i strefa DMZ

Zapora ogniowa powinna zapewniać wysoki poziom bezpieczeństwa sieci jednak bez ograniczania jej funkcjonalności. Musi ona pozwalać autoryzowanym

użytkownikom na korzystanie bez przeszkód z zasobów sieci lokalnej i Internetu, ale jednocześnie musi blokować dostęp nieznanym użytkownikom, umożliwiając

im korzystanie tylko z niewielkiej, wydzielonej części zasobów sieciowych. Ta wydzielona część zwana jest strefą DMZ (z ang. DeMilitared Zone), czyli strefą

zdemilitaryzowaną lub ograniczonego zaufania. Określenie to pochodzi z terminologii wojskowej i oznacza bufor między wrogimi siłami. Strefa DMZ stanowi

podsieć, na której działają serwery dostępne z sieci zewnętrznej (Internetu), oferujące w Interniecie usługi publiczne danej sieci lokalnej, takie jak serwis WWW, serwer FTP, etc.

W wypadku włamania na serwer w strefie DMZ, intruz i tak nie ma możliwości dostać się do wnętrza sieci lokalnej. Strefę DMZ definiuje się na samym firewallu.

Strefa DMZ stanowi tzw. obszar ryzyka czyli obszar, w którym znajdują się informacje i systemy należące do chronionej sieci lokalnej, do których haker

może uzyskać dostęp podczas ataku. Gdyby sieć lokalna była przyłączona do Internetu bez pośrednictwa firewalla i rutera, to cała stanowiłaby obszar ryzyka.

Wszystkie hosty znajdujące się w obszarze ryzyka narażone są na atak hakerów i danych znajdujących się w którymkolwiek pliku lub komputerze tej strefy nie można

uważać za poufne. Poprawnie zaprojektowana architektura sieci z firewallem ogranicza obszar ryzyka (strefę DMZ) do samej siebie lub do niewielkiej

liczby komputerów głównych w sieci.

Jeśli haker pokona firewall, siłą rzeczy obszar ryzyka rozszerza się na całą sieć. Punkt, w którym intruz pokonał zaporę, staje się bazą, z której

będzie on atakował kolejne serwery sieci. Jednak haker przedostając się do systemu przez firewall musi pozostawić ślady swojej obecności, dzięki czemu

administrator systemu wykryje włamanie. Każde wykryte włamanie dostarcza z kolei informacji, o słabych punktach w zabezpieczeniach sieci i pozwala na ich usunięcie.

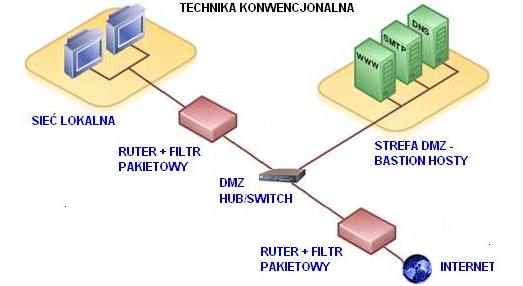

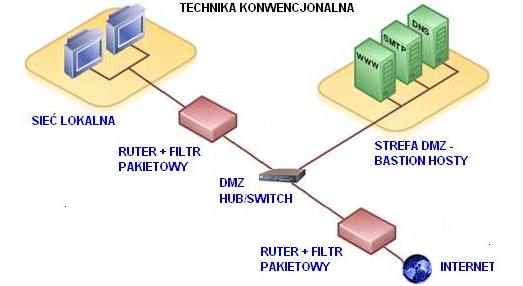

| Technika konwencjonalna

Klasyczny system firewall złożony jest z:

- zewnętrznego rutera z filtrem pakietowym

- strefy DMZ, w której świadczone będą usługi publiczne w sieci

- bastion hosta/hostów w strefie DMZ przeznaczonego do odparcia najcięższych ataków. Na danym komputerze-bastionie uruchamia się proxy serwery dla

poszczególnych usług sieciowych. Odpowiednia konfiguracja obu routerów gwarantuje, że transmisja wszelkich danych odbywa się poprzez właśnie bastion hosta.

- wewnętrznego rutera, także z filtrem pakietowym

|  |

| Technika perspektywiczna

Nowoczesne firewalle działają według zasady all-in-one. Są to pojedyncze urządzenia, które łączą w sobie funkcje

obu ruterów z filtrami pakietowymi oraz bastion hosta. Czasami dodatkowo dysponują serwisami w rodzaju DNS bądź mail. W tego rodzaju systemie

serwery typu WWW i pozostałe usługi publiczne świadczone w sieci najlepiej umieścić w osobnej sieci-strefie DMZ bezpośrednio podłączonej do

firewalla. Jednak do prawidłowej pracy takiego systemu

niezbędna jest współpraca firewalla z minimum trzema kartami sieciowymi, co w wielu przypadkach jest warunkiem trudnym do spełnienia.

| |

|

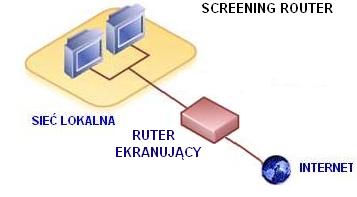

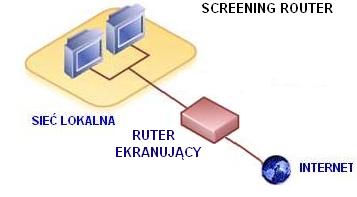

Screening Router (ruter ekranujący): Firewall postawiony jest na ruterze ekranującym lub podobnym, którego głównym zadaniem jest ochrona danych w sieci. Jest

on jedynym połaczeniem sieci prywatnej z publiczną. Pracuje w warstwie sieci selekcjonując ruch poprzez filtrowanie pakietów zależny od adresów IP oraz adresu

MAC nadawcy lub odbiorcy (MAC - z ang. Media Access Control address - sprzętowy adres karty sieciowej Ethernet i Token Ring, unikalny w skali światowej,

nadawany przez producenta danej karty podczas produkcji). Ta konfiguracja jest przykładem działania firewalla filtrującego pakiety. Mechanizm ten nie jest bezpieczny,

jeśli jest stosowany bez innych zabezpieczeń. |  |

|

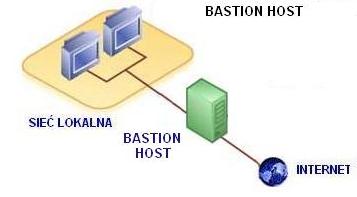

Bastion Host Firewall (firewall na komputerze bastionie): To ogólne określenie konfiguracji, w której komunikacja pomiędzy siecią lokalną, a

publiczną skupia się na jednym punkcie - bastion-hoście, na którym postawiony jest firewall. Rodzaj firewalla determinuje stopień zabezpieczenia sieci. Jeśli jest to firewall poziomu aplikacji to mamy do czynienia

z konfiguracją Application Level Gateway opisaną niżej. Jeśli jest to zwykłe filtrowanie pakietów, rozwiązanie to jest niewiele lepsze, niż ruter ekranujący.

Pośrednim rozwiązaniem jest postawienie firewalla typu stateful inspection (analiza stanu połączeń). Komputer-bastion jest szczególnie narażony na ataki z

zewnątrz sieci, dlatego powinien być jak najlepiej zabezpieczony i szczegółowo monitorowany przez administratora sieci na wypadek ewentualnych prób włamania się do sieci lokalnej.

Rozwiązanie to ma tą wadę, że nie separuje bezpośrednio obu sieci: lokalnej i publicznej, dlatego możliwe jest bezpośrednie połączenie między sieciami oraz

sama struktura sieci lokalnej i jej pojedynccze hosty są widzialne z sieci zewnętrznej.

|  |

|

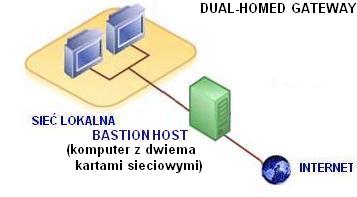

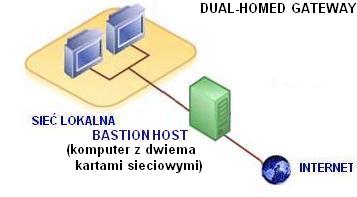

Dual-Homed Gateway Firewall (firewall na komputerze-bastionie z dwoma kartami sieciowymi): Firewall pracujący na bastion-hoście zawierającym dwa interfejsy sieciowe: jeden dla sieci prywatnej, drugi publicznej. Ruch

na warstwie sieciowej jest zablokowany, nie jest możliwe bezpośrednie przesyłanie pakietów pomiędzy obydwoma interfejsami sieciowym. Jedyny rodzaj ruchu to

ten, który generują wyszczególnione aplikacje po zalogowaniu się na komputerze-bastionie, dlatego też komputer-bastion bywa nazywany bramą (ang. gateway). Struktura sieci i

jej adresacja jest maskowana przez tą bramę. Z reguły na bastion-hoście pracuje firewall poziomu aplikacji dlatego jest to przykład zastosowania czystego mechanizmu

bramy pracującej w warstwie aplikacji.

|  |

|

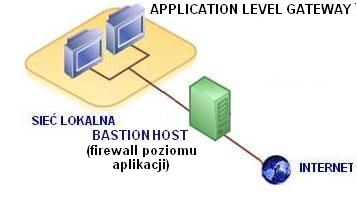

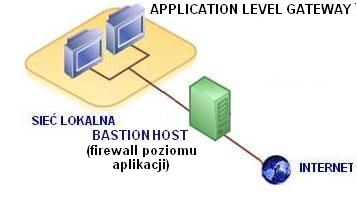

Application Level Gateway Firewall (firewall poziomu aplikacji na komputerze-bastionie): W tej konfiguracji na komputerze-twierdzy zainstalowany jest

firewall poziomu aplikacji z proxy serwerem. Rola tego komputera polega na odseparowaniu sieci na poziomie aplikacji, w odróżnieniu od Dual-Homed Gateway, gdzie sieci były

odseparowane poprzez zastosowanie dwóch różnych kart sieciowych. Oprogramowanie serwera proxy odbiera pakiety z zewnątrz i przekazuje do sieci chronionej.

Możemy postawić wiele różnych proxy serwerów na różnych maszynach zawierających oprogramowanie obsługujące poszczególne usługi sieciowe. Mechanizm ten spowalnia komunikacje, lecz

jest "przezroczysty" dla użytkownika, i w odróżnieniu od Dual-Homed Gateway nie wymaga logowania się na proxy serwerze.

|  |

|

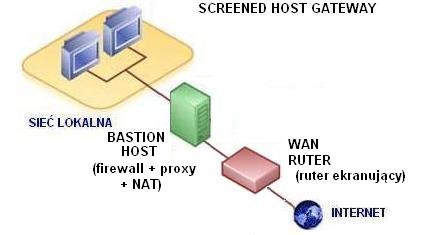

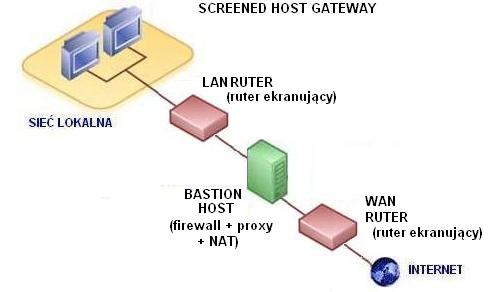

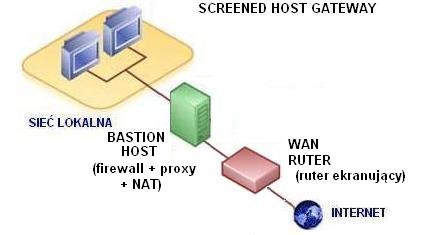

Screened Host Gateway Firewall (firewall + ruter ekranujący): Konfiguracja ta wymaga dodania WAN rutera (z ang. Wide Area Network - sieć rozległa np. Internet) dostarczającego połączenie z siecią WAN i filtrującego pakiety.

Komputer-bastion to firewall z usługami proxy i np. dodatkowym filtrowaniem pakietów i NAT-em (o NAT dalej). W konfiguracji tej zewnętrzny ruter współpracuje

z komputerem-bastionem w ten sposób, że komputer pracuje w wewnętrznej, chronionej sieci, natomiast ruter tak reguluje dostęp z zewnątrz, by ten komputer był

jedynym widzianym i dostępnym w sieci prywatnej od strony sieci publicznej. Odbywa się to dzięki filtrowaniu pakietów docierających do rutera. Dla użytkowników

zewnętrznych jedyny znany adres IP to adres komputera-twierdzy, nie widzi on struktury sieci lokalnej. Natomiast użytkownicy wewnętrzni mają dostęp do sieci zewnętrznej tylko poprzez komputer-twierdzę.

Konfiguracja ta jest przykładem syntezy dwóch typów firewalli: filtrowania pakietów przez ruter i firewalla poziomu aplikacji na komputerze-twierdzy z serwerem proxy.

|  |

|

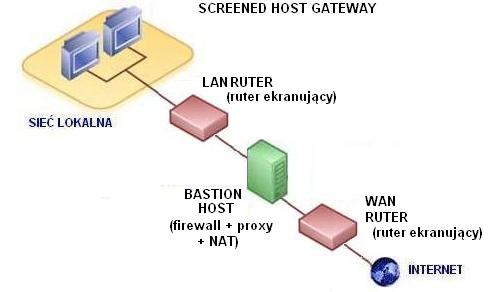

Screened Subnet Firewall (firewall + dwa rutery ekranujące): Firewall z dwoma ruterami ekranującymi stanowi dodatkową izolację sieci lokalnej.

Oprócz rutera WAN dodajemy ruter LAN, kontrolujący przepływ danych w sieci lokalnej. Komputer-twierdza z proxy serwerem jest teraz umieszczony w osobnej sieci,

dlatego atak ogranicza się jedynie do uderzenia na niego. Dodatkowy LAN ruter uniemożliwia także nieautoryzowany dostęp do komputera-bastionu z wnętrza sieci

lokalnej. Można także skonfigurować oba rutery tak, by serwer komunikował się tylko z nimi.

W architekturze tej, pomiędzy siecią chronioną, a siecią zewnętrzną znajduje się martwa strefa, strefa DMZ, w której ruch między sieciami jest częściowo blokowany. Dlatego na komputerze bastionie

możemy udostępnić usługi publiczne dla użytkowników Internetu i lokalnych, takie jak serwer WWW, FTP, etc. |  |

Systemy firewall oferują wiele dodatkowych usług, które pomagają zabezpieczyć sieć bądź też przyspieszyć jej pracę. Oto niektóre z nich:

- Serwery proxy-cache (z ang. proxy cache servers)

Usługa ta umożliwia zmniejszenie ruchu na łączu WAN poprzez przechowywanie informacji (z reguły stron WWW), do których

często odwołują się użytkownicy sieci. Zwykle serwer proxy-cache jest zintegrowany z serwerami pośredniczącymi. W przypadku przyspieszania pracy klientów